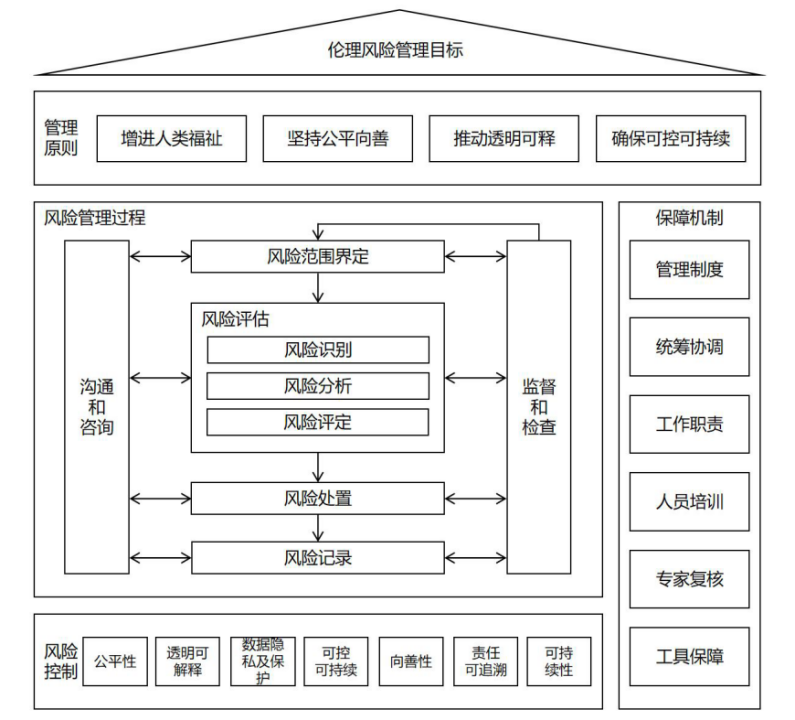

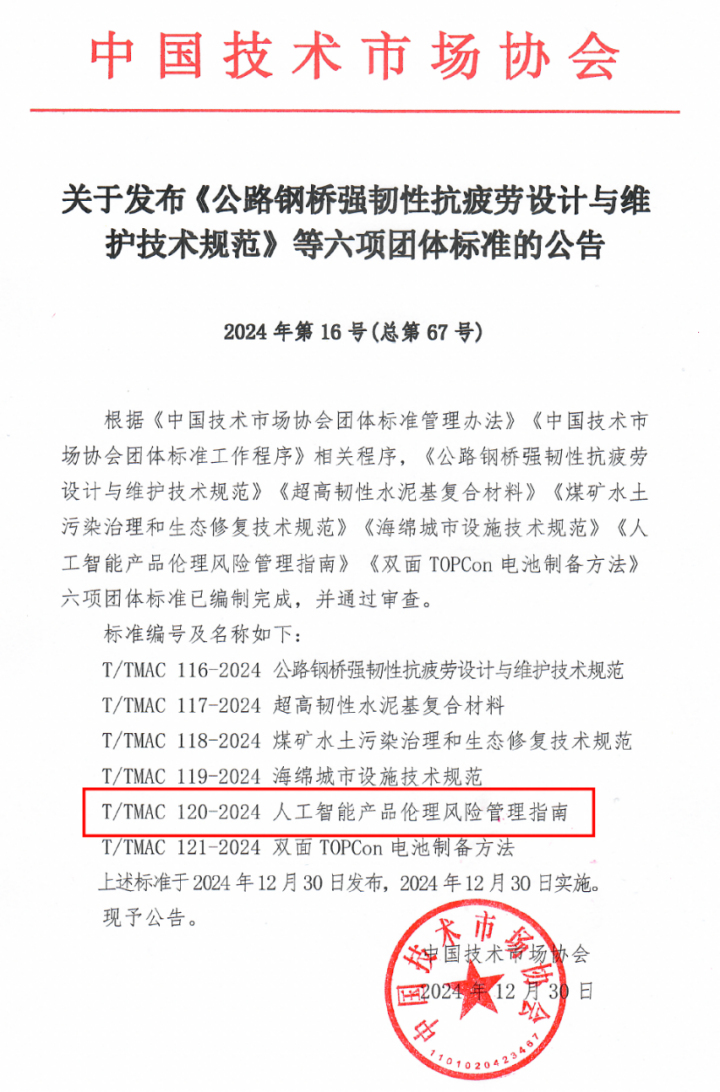

近期,中国技术市场协会发布团体标准审查的公告,其中暨南大学广东智慧教育研究院牵头,联合北京世纪好未来教育科技有限公司、哈尔滨工业大学等多家单位和高校编制的《人工智能产品伦理风险管理指南》团体标准,于2024年12月30日发布并实施。研究院院长刘子韬教授和院长助理高博宇教授为该标准的主要起草人。

【标准立项背景】 近年人工智能伦理事件频发,人工智能伦理问题及伦理风险急剧上升等现象成为社会关注重点问题之一。与此同时,在监管方面,人工智能伦理逐渐受到各国和地区用户和监管机构的重视,国内外政策法规也在逐步出台,管理机制逐渐建立;在管理方面,部分利益相关方的内、外部未设立人工智能伦理风险评估、审查机制与相关机构,相关风险管理与风险评估流程缺乏科学依据。 该文件针对人工智能产品的伦理风险,从数据、算法、应用管理等三方面开展人工智能伦理风险分析,并依据科技部《新一代人工智能伦理规范》、《科技伦理审查办法(试行)》等文件,提出人工智能产品相关的伦理风险管理体系,为人工智能技术、产品和服务利益相关方在开发和使用过程中提供一定的伦理指导依据。 |

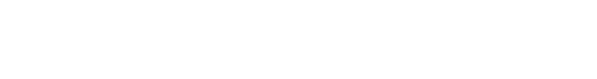

【主要技术内容】 1. 实施框架:提出了人工智能产品伦理风险管理实施框架,旨在确保人工智能产品的创新与伦理风险防范相统一。

2. 管理原则:提出4项人工智能伦理风险管理原则:增进人类福祉、坚持公平向善、推动透明可释以及确保可控可持续。 3. 管理过程:提出人工智能伦理风险管理过程,包括风险范围界定、风险评估、风险处置以及风险监督、检查与记录。 4. 控制措施:提出人工智能产品伦理风险管理控制的7项措施:公平性、透明可解释性、数据隐私及保护、可控可靠性、向善性、责任可追溯和可持续性。 5. 保障机制:提出6项人工智能产品伦理风险管理保障机制:管理制度、统筹协调、工作职责、人员培训、专家复核和工具保障。 |

【标准立项意义】 1. 规范人工智能产品开发和应用:为人工智能产品的设计、开发、部署和使用提供了一套系统的伦理风险管理框架和指导原则,有助于规范相关活动,确保其符合伦理要求。 2. 保护个人和社会权益:通过强调公平、透明、可控、可持续等原则,保障个人隐私、数据安全和社会公平,防止人工智能技术被滥用或误用,减少对个人和社会的潜在危害。 3. 促进人工智能技术的健康发展:引导人工智能技术朝着有利于人类社会的方向发展,推动科技向善,实现技术进步与社会进步的协调统一。 4. 提升公众信任和接受度:通过加强伦理风险管理,提高人工智能产品的透明度和可解释性,增强公众对人工智能技术的信任和接受度,促进其在各领域的广泛应用。 5. 应对监管要求和国际竞争:随着全球对人工智能伦理问题的重视程度不断提高,该标准有助于企业更好地应对国内外监管要求,提升其在国际竞争中的伦理形象和竞争力。 |

人工智能作为当今科技发展的前沿领域,正在深刻改变着我们的生活方式和社会结构。然而,随着人工智能技术的迅猛发展,其伦理风险和潜在问题也日益凸显。暨南大学广东智慧教育研究院始终致力于推动人工智能技术的健康发展,积极参与制定相关标准和规范,以确保人工智能技术在创新的同时,能够遵循伦理原则,造福人类社会。此次《人工智能产品伦理风险管理指南》标准的通过,标志着我国在人工智能伦理风险管理方面迈出了重要一步。未来,广东智慧教育研究院将继续秉持科技向善的理念,推动人工智能技术朝着有利于人类社会的方向发展,提升公众对人工智能技术的信任和接受度,促进其在各领域的广泛应用。